La plataforma NVIDIA HGX se ha consolidado como el “estándar de facto” para entrenar y desplegar modelos de inteligencia artificial (IA) a gran escala. Gracias a la combinación de GPUs Hopper (H100/H200) y, desde 2024, Blackwell (B200/B300), interconexión NVLink 5 con 1,8 TB/s, redes InfiniBand y Ethernet de 800 Gb/s, DPUs BlueField‑3 y un formato abierto definido por la comunidad OCP, HGX ofrece el rendimiento, la escalabilidad y la eficiencia que exigen los modelos generativos de billones de parámetros.

El reto computacional de la IA moderna

Los modelos de lenguaje y visión superan ya cientos de miles de millones de parámetros, lo que obliga a contar con infraestructuras capaces de mover gran cantidad de datos sin cuellos de botella. Con HGX, NVIDIA reúne en un único “bloque de construcción” todo lo necesario para que los centros de datos escalen desde unos pocos hasta miles de GPUs trabajando de forma conjunta.

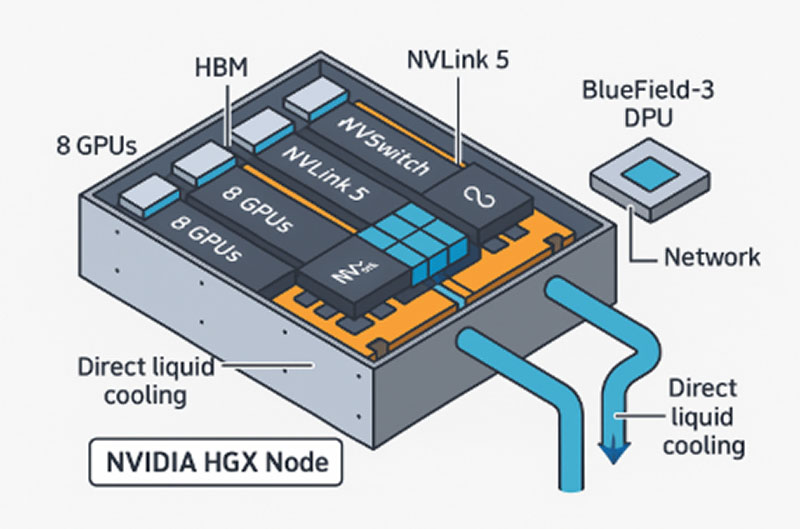

¿Cómo se organiza un nodo NVIDIA HGX?

Un nodo HGX es como un supermódulo que se instala dentro de un rack y reúne, en un mismo chasis, todo lo necesario para entrenar y servir modelos de IA sin cuellos de botella. Su arquitectura se divide en cinco bloques bien diferenciados:

- Grupo de GPUs

• De 4 a 8 GPUs Hopper (H100/H200) o Blackwell (B200/B300) montadas en zócalo SXM.

• Cada GPU incorpora memoria HBM (hasta 141 GB por chip en la H200) para sostener datasets masivos. - Red interna NVLink 5 + NVSwitch

• Hasta 1,8 TB/s de ancho de banda agregado entre GPUs, el doble que en la versión anterior.

• Permite que los ocho chips compartan memoria y actúen como una única GPU lógica. - Red externa de 800 Gb/s

• Tarjetas ConnectX‑8 y switches Quantum‑X800 (InfiniBand) o Spectrum‑X (Ethernet).

• Conecta varios nodos HGX para formar clústeres de miles de GPUs con latencias inferiores a 2 µs. - DPU BlueField‑3

• Acelera operaciones de red, almacenamiento y seguridad “cero confianza” sin robar ciclos a las GPUs.

• Según NVIDIA, libera hasta un 30 % de capacidad de cómputo que, de otro modo, quedaría ocupada por tareas de E/S. - Gestión térmica y potencia

• Consumo máximo de 6,8 kW por nodo, refrigeración líquida directa al chip y alimentación de 54 V respaldada por el Open Compute Project (OCP).

Gracias a que el factor de forma HGX está publicado en OCP, cualquier fabricante puede acoplar CPUs x86 o Arm, almacenamiento adicional o interconexiones personalizadas, manteniendo compatibilidad total con CUDA y la suite NVIDIA AI Enterprise.

Soluciones HGX disponibles hoy

- Gigabyte– Servidores G593‑SD0 (HGX H100 8‑GPU) y G59x‑B (HGX B200); versión líquida G593‑SD0‑LAX1, en producción masiva.

- ASUS– ESC N8A‑E12 (HGX H100 8‑GPU con EPYC 9004) y ESC N8‑E11V (HGX H200/H100); disponibilidad global desde finales de 2024.

- ASRock Rack– Plataforma 6U8X‑EGS2 H200 (HGX H200 8‑GPU) ya a la venta; 6U8X‑GNR2 B200 anunciada con envíos previstos para la segunda mitad de 2025.

- Supermicro– SYS‑821GE‑TNHR (HGX H100/H200 8‑GPU) y nuevos chasis ORv3 refrigerados por líquido con HGX B200 en fase de preproducción (pedidos anticipados desde Q4 2025).

En conjunto, se estima que hay más de 300 000 nodos HGX (≈ 2,4 millones de GPUs) en producción en todo el mundo, y nuestros cuatro socios —Gigabyte, ASUS, ASRock Rack y Supermicro— cubren la práctica totalidad de las configuraciones que ofrecemos a los clientes.

Ventajas clave

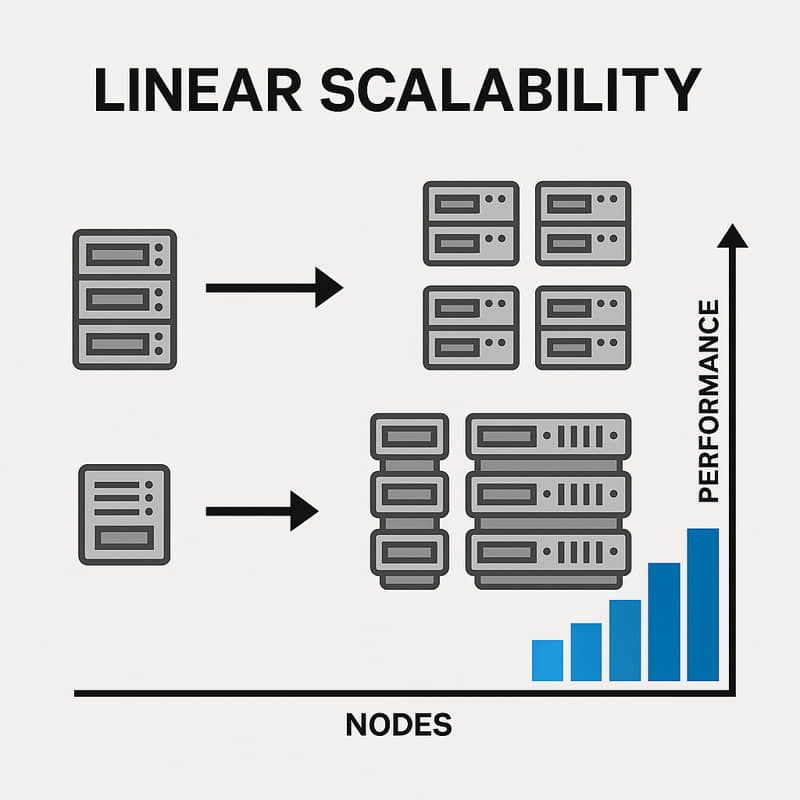

- Escalabilidad lineal: agregar nodos multiplica el rendimiento sin reescribir el software.

- Flexibilidad: compatible con CPU x86, Arm Grace o aceleradores personalizados mediante NVLink Fusion.

- Eficiencia: más rendimiento por vatio que soluciones PCIe gracias a NVLink y la memoria HBM3e.

- Seguridad: BlueField‑3 permite micro‑segmentación y cifrado de extremo a extremo sin impacto en la latencia.

- Ecosistema abierto: cualquier fabricante puede ofrecer variantes adaptadas a necesidades específicas (GPU count, refrigeración, almacenamiento).

Ventajas de HGX frente a DGX

A diferencia de los sistemas NVIDIA DGX, que se venden como soluciones cerradas “listas para usar”, el estándar HGX ofrece ventajas críticas para despliegues a gran escala o con requisitos especiales:

- Modularidad total– Permite elegir de 4 a 8 GPUs por nodo (o 72 GPUs en configuraciones NVL72) y combinarlas con la CPU preferida (x86, Grace o Arm de otros proveedores).

- Escalabilidad lineal– La interconexión NVLink 5 + NVSwitch deja crecer de un nodo a miles manteniendo la coherencia de memoria y sin reescribir el software.

- Redes de ultra‑alta velocidad– Compatible con InfiniBand y Ethernet de 800 Gb/s (y evolución a 1,6 Tb/s), mientras que DGX se limita a la topología fija incluida de fábrica.

- Refrigeración flexible– Aire, líquido directo al chip o inmersión; se adapta a la densidad térmica y a las políticas del centro de datos.

- Coste optimizado– Se compran sólo los módulos necesarios y se reutilizan racks y fuentes de alimentación existentes, reduciendo el coste por GPU frente a un servidor DGX cerrado.

- Ecosistema abierto (OCP)– La especificación pública acelera la innovación de OEM, ODM y nubes, evitando el bloqueo de proveedor.

- BlueField‑3 opcional– Añade DPUs para redes programables y seguridad de confianza cero, algo no siempre presente en la línea DGX.

Conclusión

NVIDIA HGX reúne en una única plataforma abierta la potencia bruta de las GPUs más modernas, las redes de 800 Gb/s y un ecosistema completo de software. Su adopción masiva y su presencia en las hojas de ruta de compañías como Google, Oracle y Microsoft indican que seguirá siendo el pilar sobre el que se construyen los próximos avances en IA generativa y HPC.

¿Quieres descubrir qué solución HGX se adapta mejor a tu proyecto?

Rellena este breve formulario de contacto y nuestro equipo te enviará, en menos de 24 horas, una propuesta personalizada sin compromiso.

| Cloud para IA: La tecnología detrás del cloud | Cómo Desplegar Tu Cloud Para IA Con Racks VibeRack | Nuevos Armarios Ocp V3 |

|

|

|