Introducción: la IA rompe los límites de los racks tradicionales

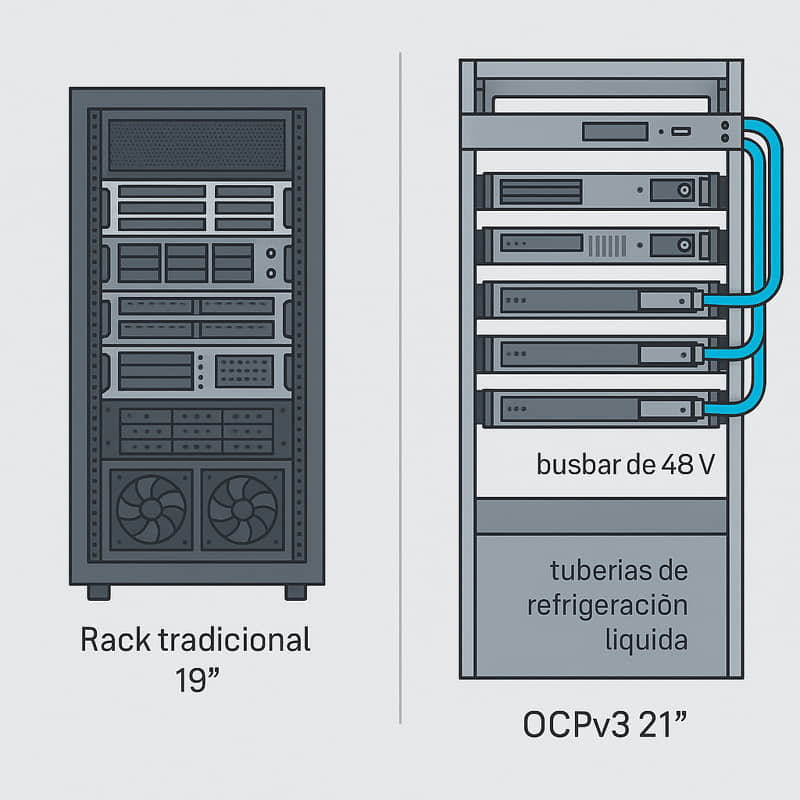

El auge de los modelos de lenguaje y visión —desde ChatGPT hasta sistemas corporativos de reinforcement learning— ha disparado la demanda de GPUs y aceleradores. Cada nodo supera ya los 1 000 W y un único clúster puede requerir más de 1 MW de potencia térmica. Los racks EIA‑310 de 19″, concebidos para cargas convencionales, no están preparados para esa densidad ni para la refrigeración líquida que impone la nueva ola de Cloud para IA. Frente a este cuello de botella emerge Open Rack v3 (Armarios rack OCP v3), la evolución más ambiciosa del proyecto de hardware abierto iniciado en 2011.

¿Qué es el Open Compute Project?

El Open Compute Project (OCP) es una comunidad global de hardware abierto fundada por Meta (entonces Facebook) en 2011. A ella se han unido gigantes como Google, Microsoft, Intel, AMD, NVIDIA, Dell, Inspur y más de 300 organizaciones académicas y proveedores de la cadena de suministro.

Su misión es diseñar y compartir especificaciones de hardware eficiente, flexible y escalable —servidores, almacenamiento, redes, energía y refrigeración— con licencias abiertas. De este modo, cualquier fabricante puede producir los diseños y cualquier operador puede adoptarlos sin quedar atado a un único proveedor, acelerando la innovación y reduciendo costes en un Cloud para IA.

Los trabajos se estructuran en Project Groups (Server, Storage, Networking, AI Hardware, Cooling, Rack & Power, Sustainability), donde los miembros colaboran publicando planos CAD, listas de materiales y firmware sin royalties.

Además, centros de supercomputación y universidades participan con contribuciones y casos de uso reales.

En síntesis, OCP no es solo un estándar de racks, sino un ecosistema abierto cuyo objetivo es democratizar la infraestructura de centros de datos y habilitar un Cloud para IA sostenible y de alto rendimiento.

Novedades de los armarios Rack OCPv3 para IA

Chasis de 21″ y bus 48 V de alta eficiencia

OCPv3 amplía la anchura de los armarios tradicionales a 21″ (≈ 15 % más ancha que el 19″ clásico) para optimizar el flujo de aire y dejar espacio a las tuberías de refrigeración líquida. La gran novedad, sin embargo, es la distribución de energía centralizada:

- Sin PSU por servidor (Servidores sin fuente de alimentación!!): los sleds OCP se insertan con un conector blind‑mate que encaja directamente en un busbar de 48 V que recorre la parte posterior del rack.

- Módulos de potencia intercambiables en caliente: la conversión de la red AC a 48 V la realizan módulos extraíbles situados en la parte superior o inferior del armario. Estos módulos de potenciaque hacen la función de fuentes de alimentación centralizada para todos los nodos del armario se agrupan en configuraciones N+1/N+N y pueden sustituirse en caliente sin detener los nodos.

- Monitorización integrada: cada módulo envía datos de corriente, tensión y temperatura a la BMC del rack, permitiendo orquestar el consumo y prevenir sobrecargas.

Con esta arquitectura se eliminan decenas de pequeñas PSUs redundantes, se reducen las conversiones y se gana eficiencia. Además, la variante HPR (High‑Power Rack) refuerza el busbar para entregar hasta 92 kW por rack, suficiente para clústeres de GPU de última generación en un Cloud para IA.

Refrigeración líquida: híbrida o directa, tú eliges

Antes de hablar de bombas y tuberías, conviene aclarar que hay dos grandes formas de enfriar un rack OCP v3:

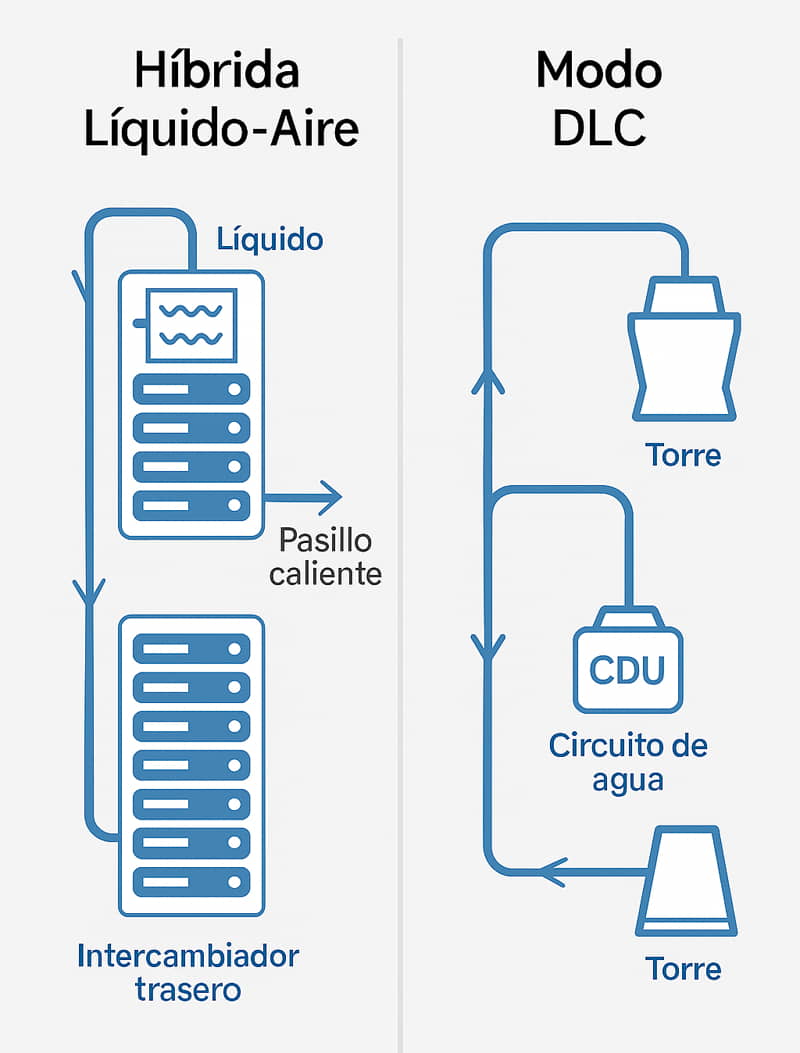

- Modo híbrido líquido‑aire

El líquido recoge el calor dentro del servidor y lo libera en un intercambiador en la puerta trasera —o en un “sidecar” lateral— que lo transfiere al aire del pasillo caliente. Así puedes seguir usando el sistema HVAC que ya tiene tu sala.

Ventajas: aprovecha la infraestructura existente, requiere solo agua a baja presión y llega sin problemas a unos 30 kW por rack.

Limitaciones: se queda corto para clústeres muy densos de GPUs donde la potencia supera los 40‑50 kW. - Modo líquido‑líquido (Direct Liquid Cooling, DLC)

Aquí todo el calor viaja por agua: del servidor pasa a un circuito tecnológico (TCL) interno y, mediante una unidad de distribución de refrigerante (CDU), al circuito de planta (Facility Water Loop, FWL) del edificio. El aire de la sala apenas se calienta.

Ventajas: disipa hasta 90 kW por rack con un PUE interno de ≈1,1, mantiene temperaturas estables todo el año y prepara la sala para futuras GPUs de >1 kW cada una.

Requisito: disponer de conexión a un loop de agua o a una torre de refrigeración externa.

¿Qué hay dentro del rack?

- Módulos de servidor con placas que tocan CPU, GPU y memoria.

- Colectores de conexión rápida antigoteo: permiten sacar o meter un servidor sin fugas ni herramientas.

- CDU inteligente con bombas y filtros redundantes que regulan caudal, presión y temperatura en tiempo real.

La lógica es sencilla: arranca en modo híbrido si tu centro de datos todavía es 100 % aire y evoluciona a DLC cuando aumentes la densidad. OCPv3 hace la transición fácil: el mismo rack admite ambos esquemas, solo hay que enchufar el bucle de agua y, si quieres, retirar el intercambiador líquido‑aire.

Gestión integrada de potencia y telemetría

El nuevo Power Monitoring Interface (PMI) amplía el viejo PMBus para agregar en un único canal I²C todos los sensores de corriente, voltaje y temperatura de los módulos de potencia, el busbar y cada sled. Este flujo se expone vía Redfish o SNMP a los sistemas de orquestación, permitiendo:

- Balanceo predictivo de carga: si un tramo del bus se acerca al 80 % de capacidad, el firmware reasigna nodos en milisegundos antes de que salten las protecciones.

- Power capping dinámico por servidor para evitar picos simultáneos cuando el clúster de GPUs entra en fase de ramp‑up.

- Mantenimiento predictivo: al correlacionar consumo, caudal de refrigerante y temperatura se detectan fugas térmicas o fuentes degradadas antes de que impacten en la producción.

La topología jerárquica (BMC por shelf + BMC de rack) reduce hasta un 60 % el tráfico de telemetría y simplifica el Zero‑Touch Provisioning en despliegues de Cloud para IA.

OCP v3 en nuestros VibeRacks: un nuevo paradigma

OCP v3 representa un cambio de paradigma en la forma de alimentar y refrigerar los centros de datos, pero todavía está dando sus primeros pasos. No sabemos si se convertirá en el próximo estándar dominante; lo que sí sabemos es que muchos fabricantes empiezan a adoptarlo y que abre la puerta a densidades y eficiencias que antes parecían inalcanzables.

En Ibertrónica queremos que dispongas de esa alternativa desde el primer día, por eso ofrecemos nuestros VibeRacks en dos sabores:

- VibeRack clásico de 19″ – ideal si tu sala está pensada para racks EIA‑310 y prefieres seguir con aire frío estándar.

- VibeRack OCPv3 de 21″ – pensado para organizaciones que buscan la máxima densidad, modularidad y, sobre todo, la opción de refrigeración líquida.

Conclusión

OCP v3 marca un antes y un después en la infraestructura para IA. Si quieres descubrir cómo nuestros VibeRacks pueden impulsar tu Cloud para IA con la máxima eficiencia y rapidez, contáctanos y diseñaremos juntos la solución que mejor se adapte a tu proyecto.

OCPv3 sienta las bases para centros de datos listos para la próxima oleada de IA generativa. Si tu organización desea construir o renovar un Cloud para IA con máxima eficiencia y escalabilidad, nuestro equipo de VibeRacks puede diseñar una solución llave en mano basada en OCPv3, refrigeración líquida y GPUs de última generación.

Contáctanos hoy y transforma tu infraestructura en el motor de tu ventaja competitiva.

| Cloud para IA: La tecnología detrás del cloud | Cómo Desplegar Tu Cloud Para IA Con Racks VibeRack | NVIDIA HGX: Plataforma Abierta que Impulsa la IA y HPC a Gran Escala |

|

|

|