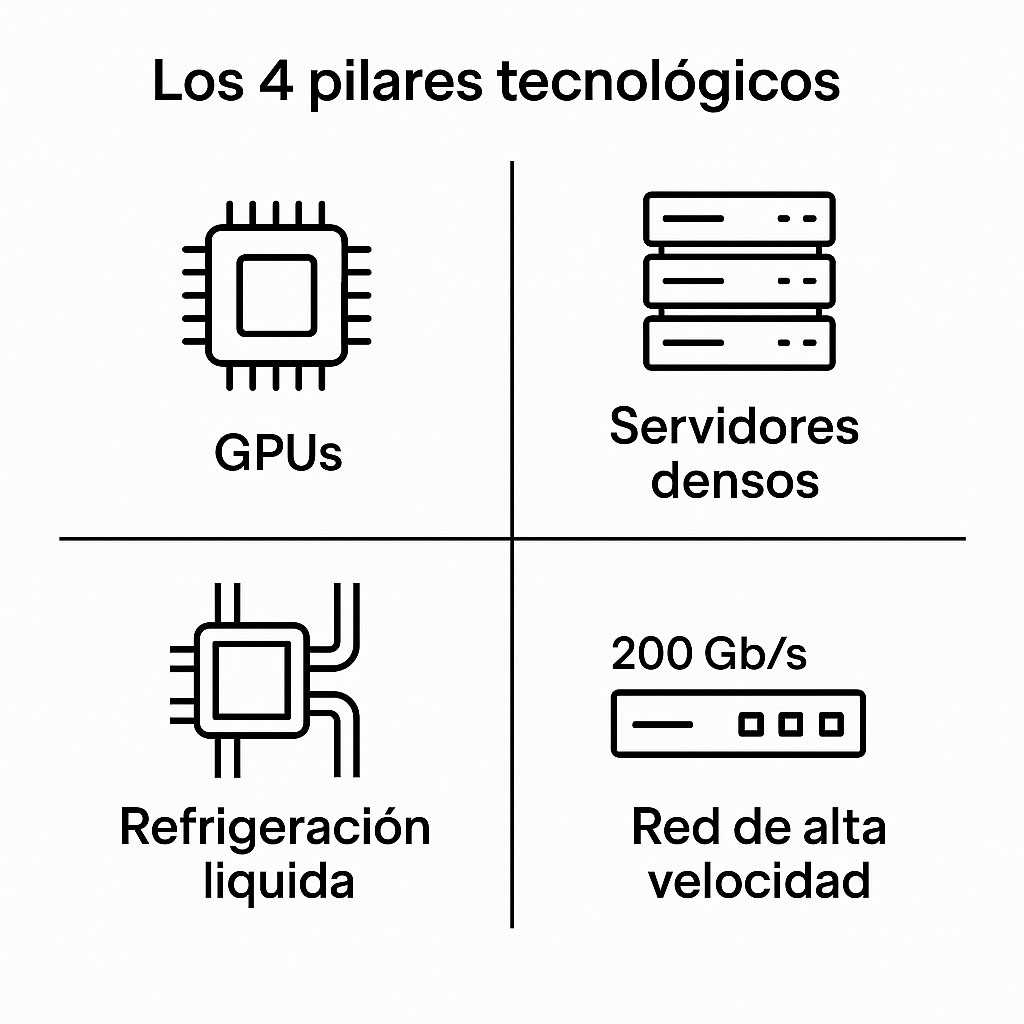

Los modelos de IA generativa actuales —capaces de manejar cientos de miles de millones de parámetros— han multiplicado exponencialmente las exigencias de computación en los centros de datos y en las nubes corporativas que los sustentan (Cloud para IA). Para entrenar e inferir estos modelos sin cuellos de botella es necesario mover terabytes de datos por segundo, disipar más de 100 kW por rack y escalar la capacidad de cálculo de forma eficiente. Este reto solo puede afrontarse apoyándose en cuatro pilares tecnológicos bien definidos:

- GPUs de última generación, con memoria HBM y enlaces NVLink/NVSwitch.

- Servidores ultradensos, que maximizan el uso de cada unidad de rack.

- Refrigeración líquida avanzada, capaz de operar con agua tibia para extraer grandes cargas térmicas.

- Redes de interconexión de alta velocidad, a partir de 200 Gb/s por nodo.

Este tipo de cloud para IA requiere una integración completa entre hardware especializado, refrigeración eficiente y conectividad de alta velocidad para soportar modelos de nueva generación.

A lo largo del artículo desgranamos cada uno de estos pilares, explicando cómo se combinan en la práctica y qué tecnologías reales los hacen posibles.

GPUs: el motor de la IA

Los procesadores gráficos lideran hoy el rendimiento computacional gracias a su capacidad masiva para realizar operaciones en coma flotante (FLOPS) y mover datos a gran velocidad. Una sola GPU moderna ofrece hasta 288 GB de memoria HBM3e y más de 8 TB/s de ancho de banda interno, cifras imposibles de alcanzar para cualquier CPU convencional.

Tarjetas como la NVIDIA H100/H200 o la nueva AMD Instinct MI350 combinan esta memoria con decenas de miles de núcleos y enlaces de alta velocidad como NVLink y NVSwitch, que permiten que varias GPUs funcionen como si fueran una sola. Esto libera a las CPUs tradicionales para tareas de coordinación, mientras las GPUs se enfocan en el cálculo intensivo.

Fabricantes como ASUS y Gigabyte ya han adaptado sus servidores para aprovechar estas capacidades. Por ejemplo, nodos con hasta ocho GPUs interconectadas por NVSwitch pueden ofrecer más de 4 PFLOPS en precisión FP16, lo que multiplica por 30 la potencia de un rack de servidores CPU convencionales.

Para aprovechar todo este rendimiento, el software debe acompañar: bibliotecas como NCCL, GPUDirect RDMA y GPUDirect Storage permiten que los datos fluyan entre GPUs, red y almacenamiento sin pasar por la RAM del sistema, reduciendo latencias a nivel de microsegundos.

Servidores densos para cloud para IA: más potencia en menos espacio

La métrica clave en un clúster de IA no es solo la potencia bruta, sino cuánta de esa potencia cabe en cada rack (FLOPS/U). Para lograr densidades extremas, se agrupan servidores con múltiples GPUs de alto rendimiento, colocados con precisión para maximizar el uso del espacio, refrigeración y conectividad interna.

Un rack de 42 U bien optimizado puede incluir:

- 4–6 servidores de 8 GPUs, interconectados mediante buses PCIe Gen5 o enlaces NVSwitch.

- Switches de red y gestión (200 Gb/s), montados en la parte superior.

- Módulos de potencia distribuidos (busbar a 48–54 V DC, exclusivos de racks OCPV3) y, según el diseño global, también módulos de control térmico o racks externos dedicados a refrigeración compartida.

Este tipo de arquitectura puede alcanzar 20–25 PFLOPS FP16 por rack. Pero el rendimiento final dependerá también del software de comunicaciones, que debe adaptarse al fabricante de las GPUs:

- Con NVIDIA: bibliotecas NCCL y GPUDirect RDMA.

- Con AMD: se usa RCCL y ROCm Direct RDMA.

- Con Intel: bibliotecas oneCCL con soporte en oneAPI/Level Zero.

Cada ecosistema tiene su propio stack optimizado, por lo que conviene definir la plataforma de hardware antes de elegir el entorno software.

Refrigeración en un cloud para IA: ¿aire o líquido?

Antes de diseñar un clúster hay que decidir cómo disipar los 20–40 kW que puede generar un rack de IA. Existen dos enfoques principales:

- Refrigeración por aire: es la más sencilla y se basa en ventiladores de alto caudal. Suele ser suficiente en instalaciones pequeñas (hasta tres racks).

- Refrigeración líquida (LC): más eficiente a partir de los 20 kW/rack. Utiliza agua glicolada para extraer calor directamente desde las GPUs y CPUs mediante cold-plates.

Dentro de LC hay dos modalidades:

- Liquid-to-Air (L2A): el agua caliente se enfría en un intercambiador dentro del rack, disipando el calor como aire templado.

- Liquid-to-Liquid (L2L): el agua transfiere su calor a un circuito externo, eliminando por completo el calor de la sala técnica.

Estas soluciones no son excluyentes. En muchos casos se combinan: por ejemplo, refrigeración líquida para GPUs y refrigeración por aire para discos y componentes secundarios.

La LC puede estar integrada en el propio rack (CDU in-rack) o gestionarse desde un armario externo que da servicio a varios racks (CDU remota).

Nota importante: la generación Blackwell de NVIDIA (B100/B200) requiere refrigeración líquida de forma obligatoria, al superar 1 kW por GPU. Las generaciones anteriores (como H100/H200) aún pueden funcionar por aire si se dispone de una sala bien acondicionada.

Redes de 200 Gb/s: mover datos sin cuellos de botella

Para entrenar modelos grandes, cada GPU puede enviar o recibir hasta 50–100 GB por iteración. En un clúster de 32 nodos, esto genera varios terabits por segundo de tráfico. Para evitar cuellos de botella, cada GPU debería tener su propia tarjeta de red (NIC) a 200 Gb/s, conectada a la red y alineada con su dominio NUMA.

Cómo se estructura la red del rack en un cloud para IA

- Conexión GPU–NIC: cada GPU se conecta a su propia NIC de 200 Gb/s (InfiniBand o Ethernet).

- Switch leaf: las NICs se conectan a switches situados en la parte superior del rack. Estos switches leaf actúan como punto de entrada a la red del clúster.

- Switch spine: cada leaf se conecta a varios spines, switches troncales que interconectan los distintos leafs. Así, cualquier GPU puede comunicarse con otra en máximo dos saltos: GPU → leaf → spine → leaf → GPU.

- Escalado: esta topología hoja-espina funciona bien hasta 256 nodos. Para despliegues más grandes se pasa a estructuras más complejas como dragonfly+.

Regla práctica:

El ancho de banda total de red del rack debe ser similar al ancho de banda de memoria agregado de sus GPUs, para no desaprovechar potencia de cálculo.

Ejemplos de hardware (200 Gb/s):

- NICs: NVIDIA ConnectX‑7, AMD Pensando DPU, Intel E810‑CQDA2

- Switches: NVIDIA InfiniBand QM9700, Broadcom Tomahawk 6 (Ethernet)

Estos componentes soportan RDMA, tecnología que permite a las GPUs intercambiar datos directamente sin pasar por la CPU, lo que mejora la eficiencia y reduce la latencia.

Conclusión: acelerar la IA sin improvisar

Adoptar IA avanzada implica transformar la infraestructura. No basta con comprar servidores potentes: hay que diseñar un cloud para IA coherente, donde cálculo, refrigeración y red trabajen en armonía.

Los servidores GPU de ASUS, Gigabyte, ASRock Rack y Supermicro muestran cómo el ecosistema ya está preparado para entregar soluciones listas para entrenar modelos de gran escala. Pero desplegarlas con éxito exige experiencia, precisión y conocimiento práctico.

ViveRack, la línea de soluciones de alto rendimiento comercializada por ibertrónica, reúne todos estos elementos en configuraciones probadas: nodos GPU certificados, distribución de refrigeración, switching a 200 Gb/s y una arquitectura lista para crecer.

👉 Si su empresa está evaluando un salto cualitativo en IA, le invitamos a conocer en detalle las configuraciones ViveRack y descubrir cómo podemos ayudarle a convertir su CPD en una verdadera fábrica de modelos.

Puede ponerse en contacto con nosotros a través del formulario disponible en nuestra web para recibir asesoramiento personalizado.

| Cómo Desplegar Tu Cloud Para IA Con Racks VibeRack | Nuevos Armarios Ocp V3 | NVIDIA HGX: Plataforma Abierta que Impulsa la IA y HPC a Gran Escala |

|

|

|